Página de Introdução ao Deep Learning

Você tem poucos conhecimentos sobre Redes Neurais? Então leia primeiro nosso material introdutório sobre redes neurais clássicas:

Redes Neurais Convolucionais (CNNs ou ConvNets) são um tipo especial de redes neurais de múltiplas camadas projetadas para reconhecer padrões visuais diretamente de pixels de imagens utilizando um mínimo de preprocessamento.

Por que CNNs produziram uma revolução na Visão Computacional? CNNs deitaram por terra o tradicional modelo em passos de abstração crescente da pipeline de processamento de imagens: filtragem, simplificação, extração de caracterísiticas e classificação. CNNs podem ser treinadas para fazer isso tudo de forma integrada, com resultados muito superiores.

Por que os resultados de CNNs são superiores? A extração de caracterísitcas, no modelo tradicional, é estática e dependente de algoritmos prontos. Alguns deles são extremamente complexos como SIFT, SURF ou ORB, e que, para descrever o conteúdo das imagens, extraem determinados tipos de características dessas imagens ou de partes delas resultantes de uma simplificação (ex.: segmentação) realizada anteriormente. Extratores de caractercterísitcas não são adaptativos: eles são algoritmos projetados para funcionarem de uma determinada maneira com muito esforço por pessoas ao longo de anos de pesquisa. Se o conjunto de extratores de caracterísitca que você está usando para descrever o conteúdo de suas imagens não é capaz de gerar características discriminantes para o seu problema, isto é, que permitam distingüir adequadamente entre as diferentes categorias de imagem em seu problema particular (ex.: caminhões, motos e bicicletas), não adianta nada o resto de sua pipeline (filtros, simplificadores, classificadores) ser maravilhoso. Nenhum classificador vai ser capaz de classificar adequadamente imagens que tenham sido descritas com base em conjuntos de características que não conseguem dizer algo de útil para diferenciar entre suas categorias. As camadas convolucionais das CNNs, por outro lado, aprendem descritores de características específicos, customizados para os exemplos de treinamento que você fornece ao treinar a rede. Isso acontece de forma integrada aos outros passos do processo de interpretação ou de classificação de uma imagem. Dessa forma uma CNN com a arquitetura correta e que tenha sido adequadamente treinada substitui uma pipeline de processamento de imagens inteira.

O que vamos aprender nesta parte da Disciplina? Nós vamos entender o que é uma CNN e o que a diferencia das Redes Neurais tradicionais. Vamos também aprender a usar algumas ferramentas de desenvolvimento de CNNs e analisar vários tipos de arquiteturas de CNNs e descobrir para que tipos de problemas servem. O enfoque será prático, voltado à resolução de problemas reaproveitando código e modelos existentes. Apresentaremos a teoria sempre que for necessário.

Contents

Modelos e Arquiteturas

Adquira uma visão panorâmica:

- Introdução MUITO boa: A Selective Overview of Deep Learning – Jianqing Fan, Cong Ma, Yiqiao Zhong (Abril, 2019). Deep learning has arguably achieved tremendous success in recent years. In simple words, deep learning uses the composition of many nonlinear functions to model the complex dependency between input features and labels. While neural networks have a long history, recent advances have greatly improved their performance in computer vision, natural language processing, etc. From the statistical and scientific perspective, it is natural to ask: What is deep learning? What are the new characteristics of deep learning, compared with classical methods? What are the theoretical foundations of deep learning? To answer these questions, we introduce common neural network models (e.g., convolutional neural nets, recurrent neural nets, generative adversarial nets) and training techniques (e.g., stochastic gradient descent, dropout, batch normalization) from a statistical point of view. Along the way, we highlight new characteristics of deep learning (including depth and over-parametrization) and explain their practical and theoretical benefits. We also sample recent results on theories of deep learning, many of which are only suggestive. While a complete understanding of deep learning remains elusive, we hope that our perspectives and discussions serve as a stimulus for new statistical research.

- Revisão dos Modelos: The History Began from AlexNet: A Comprehensive Survey on Deep Learning Approaches, 2018

- Revisão focada em Imagens: Deep Convolutional Neural Networks for Image Classification: A Comprehensive Review. Waseem Rawat and Zenghui Wang. Neural Computation

Volume 29 | Issue 9 | September 2017, p.2352-2449 - Medium: CNN Architectures: LeNet, AlexNet, VGG, GoogLeNet, ResNet and more ….

- CV-Tricks: ResNet, AlexNet, VGGNet, Inception: Understanding various architectures of Convolutional Networks

Por que escolhemos Keras?

O objetivo desta disciplina é ensinar Visão Computacional e não tópicos avançados em redes convolucionais. CNNs são ferramentas e não o objetivo de aprendizado. Keras é uma biblioteca de Redes Neurais em Python, simples de usar construída sobre plataformas consagradas como Theano e TensorFlow e que permite a prototipagem rápida de ideias e modelos: é o amniente ideal para o desenvolvedor de aplicações usando CNNs realizar a prototipagem e adaptação com modelos existentes. A não ser que você esteja realizando alguma pesquisa de ponta em modelos de redes neurais, Keras vai lhe prover todos os recursos de forma rápida. Tem a vantagem de possuir muitos exemplos, tutoriais e coisas prontas para você reusar.

Outra Plataformas: Material do LAPIX/INCoD

Se você está procurando usar outras plataformas, aqui há material e tutoriais para as principais:

Se você não tem um bom computador em casa, veja aqui as alternativas:

Olhe também nossa seção abaixo Como executar na Nuvem?

Tutoriais de Keras

Intros!

Nesta seção vamos dirigir exercícios introdutórios ao uso de Keras com TensorFlow. Se você deseja outra coisa, procure por outros exemplos mais abaixo.

- Redes Neurais Tradicionais: vamos fazer alguns testes usando o simulador de TensorFlow

- Satya Mallick: Deep learning using Keras – The Basics

- Medium::Understanding Convolutional Neural Networks(CNNs)

- CVTricks Keras tutorial: Practical guide from getting started to developing complex deep neural network

- Tutorial passo-a-passo do Towards Data Science: Building a Convolutional Neural Network (CNN) in Keras

- Tutorial bem introdutório do Towards Data Science: Build Your Own Convolution Neural Network in 5 mins – An introduction to CNN and code (Keras)

- PyImagesearch: Keras Tutorial: How to get started with Keras, Deep Learning, and Python – Tutorial interessante: vai logo para o uso de um conjunto de treinamento customizado do aluno

- TensorFlow: Learn and use machine learning

- DataCamp: Keras Tutorial: Deep Learning in Python

- Medium::Convolutional Neural Networks: Training a Convolutional Network from Scratch (pun totally intended)

- Aprendizagem de Máquina é Divertido! Parte 3 – Deep Learning e Redes Neuronais Convolutivas – Um raríssimo texto em Português do Prof. Josenildo Costa da Silva do IFMA)

Para começar

Aqui há bastante material focando em Keras…

- Deep Learning::Instalando Keras

Para usar Keras adequadamente você vai necessitar de TensorFlow:

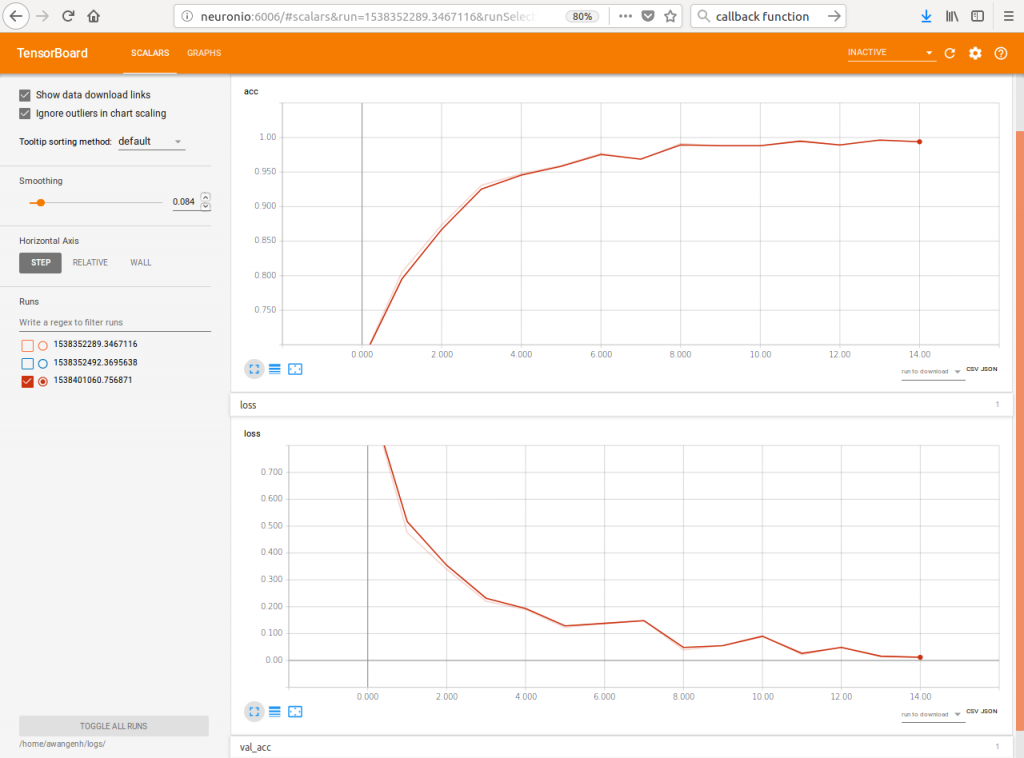

- Deep Learning::Callbacks para Salvar Resultados Intermediários e Visualizar na Web com TensorBoard

TensorBoard sobre resultados gerados com Keras

Preparando seu Computador

- Medium::Setting up a Ubuntu 18.04.1 LTS system for deep learning and scientific computing

- Towards Data Science::How to Setup a Python Environment for Machine Learning

Visualização de Representação Interna e Resultados Intermediários de CNNs

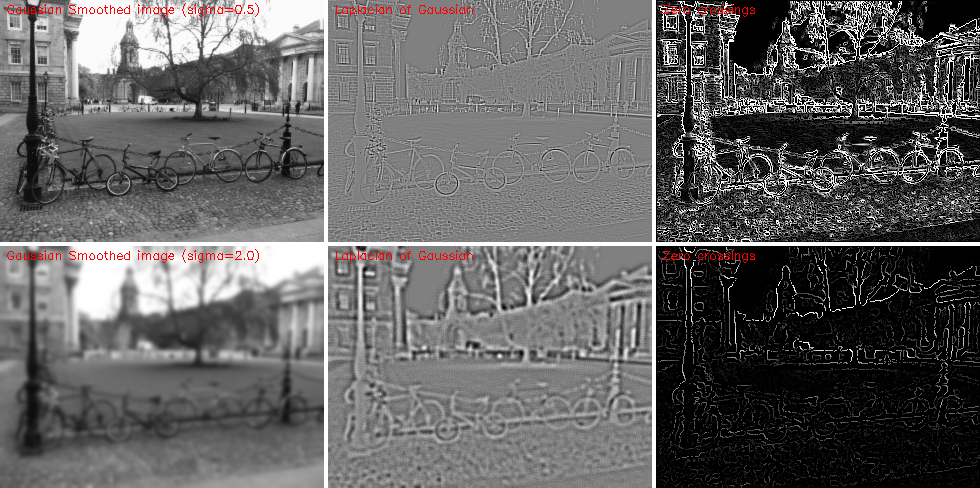

No processamento de imagens tradicional estamos acostumados a aplicar convoluções específicas, pré-definidas, sobre imagens e imediatamente ver os resultados. A título de exemplo, a figura abaixo mostra diferentes combinações de Gaussiano e Laplaciano sobre uma imagem.

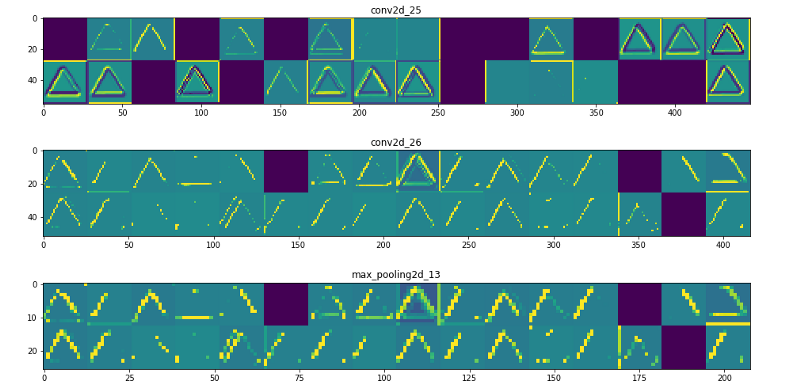

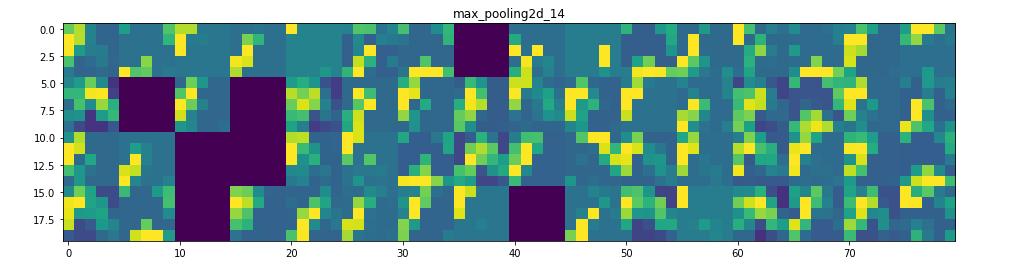

Em CNNs isso é diferente: Redes neurais backpropagation foram durante muitos anos criticadas por serem soluções caixa-preta onde a representação interna do que foi aprendido não é acessível. CNNs, no entanto, aprendem convoluções customizadas e o resultado dessas convoluções pode ser visualizado! Basta acessar as ativações das diferentes camadas da rede, para diferentes imagens de entrada. Abaixo alguns exemplos de como fazer isto:

- Towards Data Science::Understanding your Convolution network with Visualizations

- Se você deseja visualizar representações intermediárias e ativações, aqui há toques de como fazer isto em Keras puro: Towards Data Science::Visualizing intermediate activation in Convolutional Neural Networks with Keras

- Aula: Stanford CS231n::Visualizing what ConvNets learn

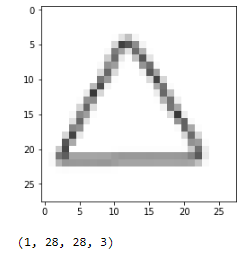

Adiante você pode ver a imagem de um triângulo e as representações que a rede neural convolucional aprendeu para este triângulo em diferentes camadas (são figuras do segundo material acima – lá há mais detalhes e ilustrações:

Stanford CS231n::Lecture 12 | Visualizing and Understanding:

Links de Visualização de Representação em Redes

- t-SNE visualization of CNN codes (t-Distributed Stochastic Neighbor Embedding (t-SNE) é uma forma de quantificação de vetores não linear)

- deepvis::Understanding Neural Networks Through Deep Visualization

- Git da ferramenta: https://github.com/yosinski/deep-visualization-toolbox

- Visualização do processo de treinamento (código de CNN em JavaScript) de Andrej Karpathy: ConvNetJS CIFAR-10 demo

- API JS para CNNs de Karpathy: https://cs.stanford.edu/people/karpathy/convnetjs/

- Git: https://github.com/karpathy/convnetjs

Links

Keras Básico

Aprendendo a Melhor Arquitetura: Neural Architecture Search (NAS)

- Artigo original sobre Neural Architecture Search (NAS): Barret Zoph, Vijay Vasudevan, Jonathon Shlens, Quoc V. Le: Learning Transferable Architectures for Scalable Image Recognition, ArXiv, 2017

- Towards Data Science::AutoKeras: The Killer of Google’s AutoML

- Towards Data Science::Everything you need to know about AutoML and Neural Architecture Search

- Artigo obre AutoKeras: Auto-Keras: Haifeng Jin, Qingquan Song, Xia Hu: Efficient Neural Architecture Search with Network Morphism, ArXiv, 2018

- Página Oficial do Autokeras: http://autokeras.com/

- Github do Autokeras: https://github.com/jhfjhfj1/autokeras

- NAS para Tensor Flow: Efficient Neural Architecture Search via Parameter Sharing

- NAS para Pytorch: PyTorch implementation of “Efficient Neural Architecture Search via Parameters Sharing”

Como executar na Nuvem?

Montar a sua estação de processamento em GPU para Deep Learning é algo caro e um investimento com altíssima taxa de depreciação, considerando-se a velocidade com a qual novos modelos de GPU são lançados e a taxa com que novos modelos, cada vez maiores, de redes neurais, são desenvolvidos. Uma estação do preço de um carro daqui há dois anos pode estar tão depreciada que não servirá para mais nenhuma pesquisa séria. Por que não alugar um espaço com hardware de última geração para desenvolver o que você quer?

Uma série de provedores de serviços em nuvem vem oferecendo a possibilidade de desenvolver, treinar e executar CNNs em susas nuvens, geralmente em ambientes especiais, separados dos outros serviços em nuvem. Características:

- Custos e Uso Gratuito: Praticamente todos oferecem pacotes grátis para você testar ou uso gratuito em partes do processo de desenvolvimento, como por exemplo modelagem e debugação. Alguns, como GoogleCloud, dão crédito inicial para quem tem conta Google, outros possuem sistema de créditos em troca de divulgação e propaganda, como Paperspace. Alguns tem uma armadilha associada: as redes serão parcialmente baseadas em bibliotecas proprietárias e só vão rodar naquela nuvem, obrigando você a continuar alugando os serviços depois ao invés de fazer o deply em sua máquina no seu lab. Olhe bem o que vai usar.

- Ferramentas de desenvolvimento: a maioria oferece IDEs de desenvolvimento baseadas em Jupyter Notebooks. Uma exceção é IBM Watson Studio, que oferece uma ferramenta de programação visual para modelagem, estilo Scratch ou Blockly.

- Frameworks: Supostamente todos deveriam suportar todos os principais frameworks, mas isso é variável. Google vai fazer propaganda de TensorFlow e tornar o uso desse mais fácil, por exemplo. Em algumas palatformas você tem de instalar tudo o que sua máquina virtual vai usar, outras geram máquinas virtuais com tudo pré-instalado.

GoogleCloud

- Usando Google Colaboratory:

- Se você tem uma conta Google, você tem direito a 300 horas de processamento na Google Cloud:

- Como estamos usando TensorFlow, é possível inclusive usar a nova arquitetura de TPU da Google: https://cloud.google.com/tpu/

- https://www.blog.google/products/google-cloud/google-cloud-offer-tpus-machine-learning/

- https://blog.goodaudience.com/how-to-use-google-cloud-tpus-177c3a025067?gi=37469eca628c

- https://www.theregister.co.uk/2018/06/20/google_cloud_tpus/

- Na Internet está cheio de turoriais de como usar TensorFlow pela interface

Paperspace

Paperspace tem sido bastante discutido e citado. Tem suporte especial aos cursos do fast.ai.

- Site: https://www.paperspace.com/

- Ambiente de desenvolvimento: Gradient

- Tutorial -> Towards Data Science: How to use Paperspace to train your Deep Neural Networks

BigML

BigML é diferente dos outros provedores em nuvem pelo fato de não estar associado a nenhuma grande empresa de processamento de dados ou fabricante de computadores, sendo uma empresa voltada a esse fim. Em função disso possui vários programas acadêmicos que se deve explorar e também a vantagem de ser agnóstico a plataforma e framework: Aqui você pode desenvolver, treinar e rodar tudo e depois levar para casa.

Amazon Web Services – AWS

- AWS

- Amazon EC2

- Amazon SageMaker: A fully-managed platform that enables developers and data scientists to quickly and easily build, train, and deploy machine learning models at any scale and removes all the barriers that typically slow down developers who want to use machine learning.

- SageMaker oferece uma grande variedade de configurações de hardware virtual para você usar: https://aws.amazon.com/sagemaker/pricing/instance-types/

- Amazon Machine Learning Developer Guide

FloydHub

FloydHub é uma plataforma para desenvolvimento e execução de CNNs extremamente simples:

- Site: https://www.floydhub.com/

- FloydHub Workspace é uma IDE de desenvolvimento online (baseada em Jupyter): https://www.floydhub.com/product/build

- Suporta TensorFlow, Keras, Caffe e Pytorch

Microsoft Azure Machine Learning Studio

- Site: https://azure.microsoft.com/en-us/services/machine-learning-studio/

- Possui uma ferramenta: Azure AI -Artificial intelligence productivity for virtually every developer and scenario

- Exemplo: Defect detection with image analysis

IBM Watson Studio

- IBM’s experiment-centric deep learning service within Watson Studio allows data scientists to visually design their neural networks and scale out their training runs while auto-allocation means paying only for the resources utilized.

- Tutorial: Generate restaurant reviews using deep learning

Disscussão dos Provedores

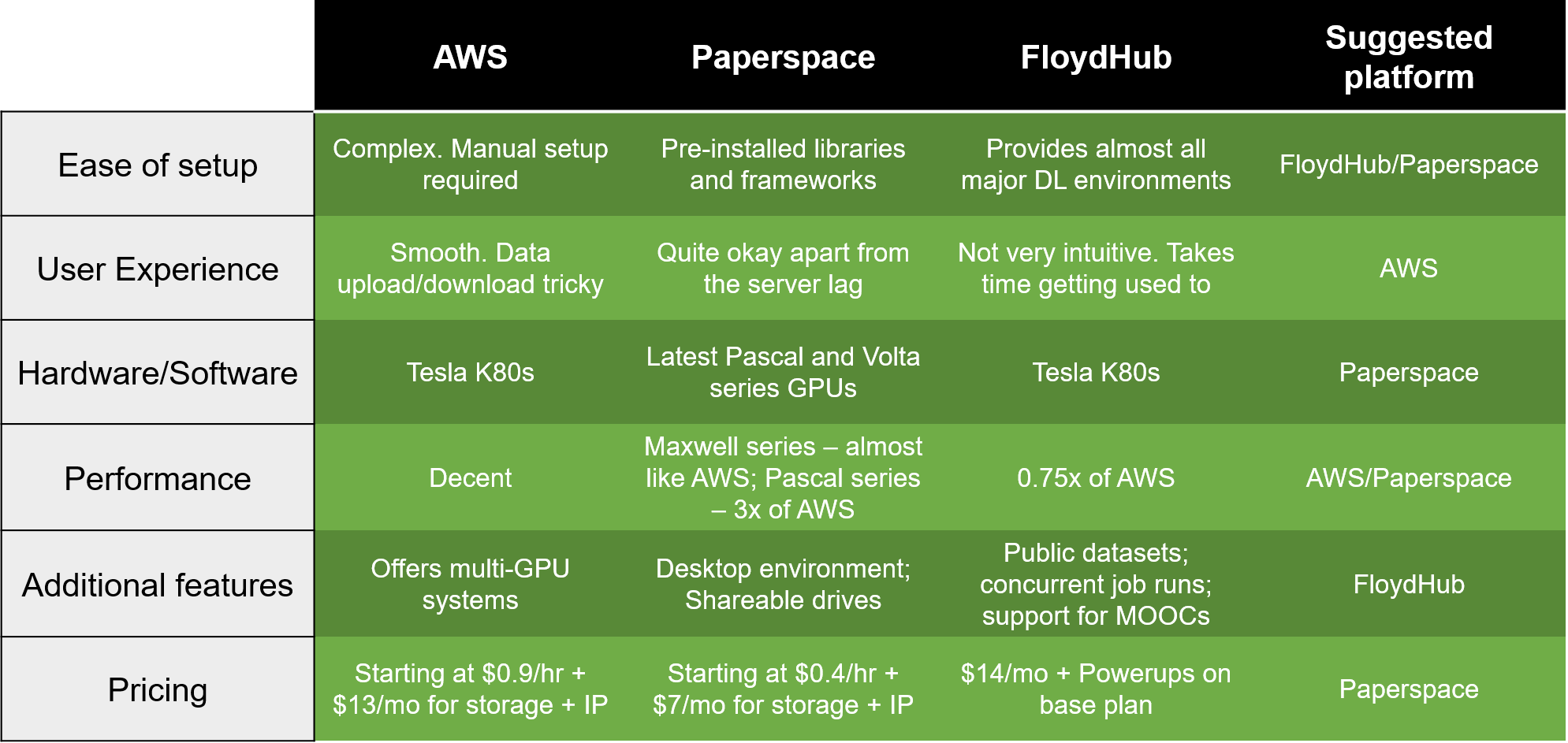

- Medium: AWS vs Paperspace vs FloydHub : Choosing your cloud GPU partner

- Top 5 Machine Learning-as-a-Service providers

Videos Introdutórios

Se você não sabe nada acerca de Redes Neurais, assista este video primeiro, que vai levá-lo, em um exemplo ultrasimples, do Zero Absoluto até Redes com Imagens:

Estes são videos de cursos de Redes Convolucionais, mas começam do be-a-bá também:

Veja todas as 16 aulas aqui: Lecture Collection | Convolutional Neural Networks for Visual Recognition (Spring 2017) – Stanford University School of Engineering

Páginas Correlatas neste Site

Reconhecimento de Padrões

- Reconhecimento de Padrões::Técnicas Sub-simbólicas: Redes Neurais

- Reconhecimento de Padrões::Técnicas Simbólicas: Aprendizado de Máquina

Copyright © 2018 Aldo von Wangenheim/INCoD/Universidade Federal de Santa Catarina